Dans ce didacticiel, nous allons vous montrer comment installer Apache Spark sur Debian 11. Pour ceux d'entre vous qui ne le savaient pas, Apache Spark est une application gratuite, open source et polyvalente. framework pour l'informatique en cluster. Il est spécialement conçu pour la vitesse et est utilisé dans l'apprentissage automatique pour diffuser le traitement de requêtes SQL complexes. Il prend en charge plusieurs API pour le streaming, le traitement des graphes, notamment Java, Python, Scala et R. Spark est principalement installé dans Clusters Hadoop, mais vous pouvez également installer et configurer Spark en mode autonome.

Cet article suppose que vous avez au moins des connaissances de base sur Linux, que vous savez utiliser le shell et, plus important encore, que vous hébergez votre site sur votre propre VPS. L'installation est assez simple et suppose que vous s'exécutent dans le compte root, sinon vous devrez peut-être ajouter 'sudo ‘ aux commandes pour obtenir les privilèges root. Je vais vous montrer étape par étape l'installation d'Apache Spark sur une Debian 11 (Bullseye).

Prérequis

- Un serveur exécutant l'un des systèmes d'exploitation suivants :Debian 11 (Bullseye).

- Il est recommandé d'utiliser une nouvelle installation du système d'exploitation pour éviter tout problème potentiel.

- Un

non-root sudo userou l'accès à l'root user. Nous vous recommandons d'agir en tant qu'non-root sudo user, cependant, car vous pouvez endommager votre système si vous ne faites pas attention lorsque vous agissez en tant que root.

Installer Apache Spark sur Debian 11 Bullseye

Étape 1. Avant d'installer un logiciel, il est important de s'assurer que votre système est à jour en exécutant le suivant apt commandes dans le terminal :

mises à jour de sudo aptmises à jour de sudo apt

Étape 2. Installation de Java.

Exécutez la commande suivante ci-dessous pour installer Java et d'autres dépendances :

sudo apt install default-jdk scala git

Vérifiez l'installation de Java à l'aide de la commande :

java --version

Étape 3. Installer Apache Spark sur Debian 11.

Nous téléchargeons maintenant la dernière version d'Apache Spark depuis la page officielle en utilisant wget commande :

wget https://dlcdn.apache.org/spark/spark-3.1.2/spark-3.1.2-bin-hadoop3.2.tgz

Ensuite, extrayez le fichier téléchargé :

tar -xvzf spark-3.1.2-bin-hadoop3.2.tgzmv spark-3.1.2-bin-hadoop3.2/ /opt/spark

Après cela, modifiez le ~/.bashrc fichier et ajoutez la variable de chemin Spark :

nano ~/.bashrc

Ajoutez la ligne suivante :

export SPARK_HOME=/opt/sparkexport PATH=$PATH:$SPARK_HOME/bin:$SPARK_HOME/sbin

Enregistrez et fermez le fichier, puis activez la variable d'environnement Spark à l'aide de la commande suivante :

source ~/.bashrc

Étape 3. Démarrez le serveur maître Apache Spark.

À ce stade, Apache Spark est installé. Démarrons maintenant son serveur maître autonome en exécutant son script :

start-master.sh

Par défaut, Apache Spark écoute sur le port 8080. Vous pouvez le vérifier avec la commande suivante :

ss -tunelp | grep 8080

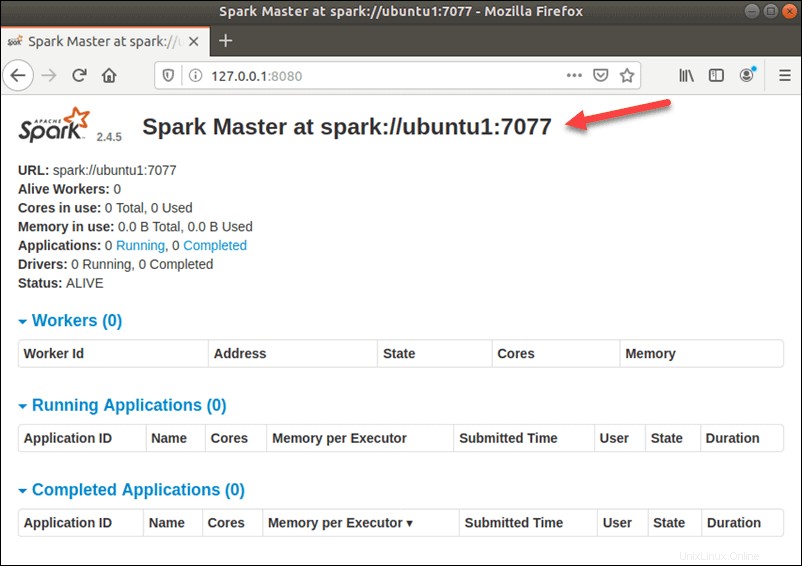

Étape 4. Accéder à l'interface Web Apache Spark.

Une fois configuré avec succès, accédez maintenant à l'interface Web d'Apache Spark à l'aide de l'URL http://your-server-ip-address:8080 . Vous devriez voir le service maître et esclave Apache Spark sur l'écran suivant :

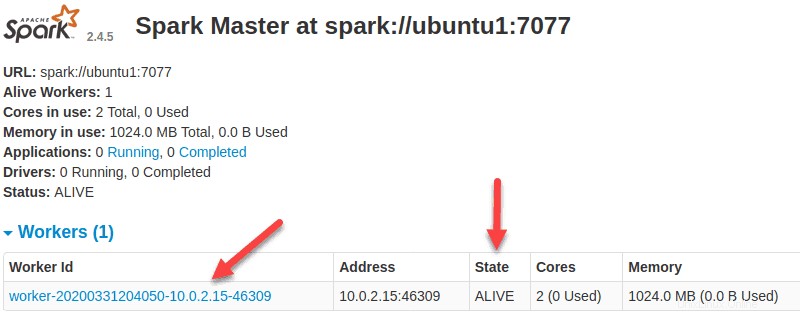

Dans cette configuration autonome à serveur unique, nous allons démarrer un serveur esclave avec le serveur maître. Le start-slave.sh la commande est utilisée pour démarrer le Spark Worker Process :

start-slave.sh spark://ubuntu1:7077

Maintenant qu'un worker est opérationnel, si vous rechargez l'interface utilisateur Web de Spark Master, vous devriez le voir dans la liste :

Une fois la configuration terminée, démarrez le serveur maître et esclave, testez si le shell Spark fonctionne :

étincelle-shell

Vous obtiendrez l'interface suivante :

Spark disponible en tant que 'spark'.Bienvenue à ____ __ / __/__ ___ _____/ /__ _\ \/ _ \/ _ `/ __/ '_/ /___/ .__/\_,_/ _/ /_/\_\ version 3.1.2 /_/ Utilisation de Scala version 2.12.10 (OpenJDK 64-Bit Server VM, Java 11.0.12)Tapez des expressions pour les évaluer.Tapez :help pour plus d'informations.scala>Félicitations ! Vous avez installé Apache Spark avec succès. Merci d'avoir utilisé ce didacticiel pour installer la dernière version d'Apache Spark sur Debian 11 Bullseye. Pour obtenir de l'aide supplémentaire ou des informations utiles, nous vous recommandons de consulter le Site Web Apache Spark.