Dans ce didacticiel, nous allons vous montrer comment installer Apache Spark sur Debian 10. Pour ceux d'entre vous qui ne le savaient pas, Apache Spark est un système informatique en cluster rapide et polyvalent. Il fournit des API de haut niveau en Java, Scala et Python, ainsi qu'un moteur optimisé qui prend en charge les graphiques d'exécution globaux. Il prend également en charge un riche ensemble d'outils de niveau supérieur, notamment Spark SQL pour SQL et le traitement de l'information structurée, MLlib pour l'apprentissage automatique. , GraphX pour le traitement des graphes et Spark Streaming.

Cet article suppose que vous avez au moins des connaissances de base sur Linux, que vous savez utiliser le shell et, plus important encore, que vous hébergez votre site sur votre propre VPS. L'installation est assez simple et suppose que vous s'exécutent dans le compte root, sinon vous devrez peut-être ajouter 'sudo ‘ aux commandes pour obtenir les privilèges root. Je vais vous montrer étape par étape l'installation d'Apache Spark sur une Debian 10 (Buster).

Prérequis

- Un serveur exécutant l'un des systèmes d'exploitation suivants :Debian 10 (Buster).

- Il est recommandé d'utiliser une nouvelle installation du système d'exploitation pour éviter tout problème potentiel.

- Un

non-root sudo userou l'accès à l'root user. Nous vous recommandons d'agir en tant qu'non-root sudo user, cependant, car vous pouvez endommager votre système si vous ne faites pas attention lorsque vous agissez en tant que root.

Installer Apache Spark sur Debian 10 Buster

Étape 1. Avant d'exécuter le didacticiel ci-dessous, il est important de vous assurer que votre système est à jour en exécutant le suivant apt commandes dans le terminal :

sudo apt update

Étape 2. Installation de Java.

Apache Spark nécessite Java pour s'exécuter, assurons-nous que Java est installé sur notre système Debian :

sudo apt install default-jdk

Vérifiez la version de Java à l'aide de la commande :

java -version

Étape 3. Installation de Scala.

Nous installons maintenant le package Scala sur les systèmes Debian :

sudo apt install scala

Vérifiez la version de Scala :

scala -version

Étape 4. Installer Apache Spark sur Debian.

Nous pouvons maintenant télécharger le binaire Apache Spark :

wget https://www.apache.org/dyn/closer.lua/spark/spark-3.1.1/spark-3.1.1-bin-hadoop2.7.tgz

Ensuite, extrayez l'archive Spark :

tar xvf spark-3.1.1-bin-hadoop2.7.tgz sudo mv spark-3.1.1-bin-hadoop2.7/ /opt/spark

Une fois terminé, définissez l'environnement Spark :

nano ~/.bashrc

À la fin du fichier, ajoutez les lignes suivantes :

export SPARK_HOME=/opt/spark export PATH=$PATH:$SPARK_HOME/bin:$SPARK_HOME/sbin

Enregistrez les modifications et fermez l'éditeur. Pour appliquer les modifications, exécutez :

source ~/.bashrc

Démarrez maintenant Apache Spark avec ces commandes, dont l'une est le maître du cluster :

start-master.sh

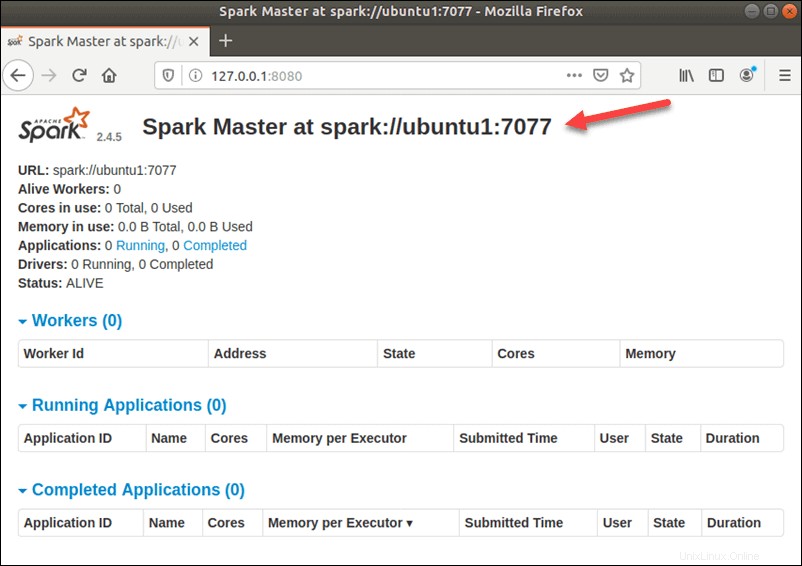

Pour afficher l'interface utilisateur Web Spark comme ci-dessous, ouvrez un navigateur Web et entrez l'adresse IP de l'hôte local sur le port 8080 :

http://127.0.0.1:8080/

Dans cette configuration autonome à serveur unique, nous allons démarrer un serveur esclave avec le serveur maître. Le start-slave.sh une commande est utilisée pour démarrer le Spark Worker Process :

start-slave.sh spark://ubuntu1:7077

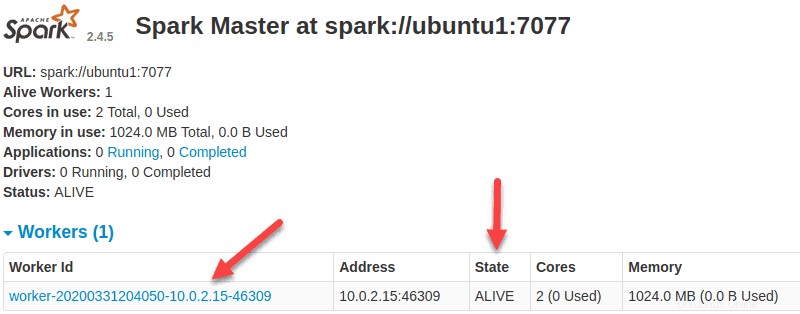

Maintenant qu'un travailleur est opérationnel, si vous rechargez l'interface utilisateur Web de Spark Master, vous devriez le voir dans la liste :

Une fois la configuration terminée, démarrez le serveur maître et esclave, testez si le shell Spark fonctionne :

spark-shell

Félicitations ! Vous avez installé Spark avec succès. Merci d'avoir utilisé ce didacticiel pour installer la dernière version d'Apache Spark sur le système Debian. Pour obtenir de l'aide supplémentaire ou des informations utiles, nous vous recommandons de consulter la version officielle d'Apache Site Web Spark.