Voici le planning des configurations tuned-adm...

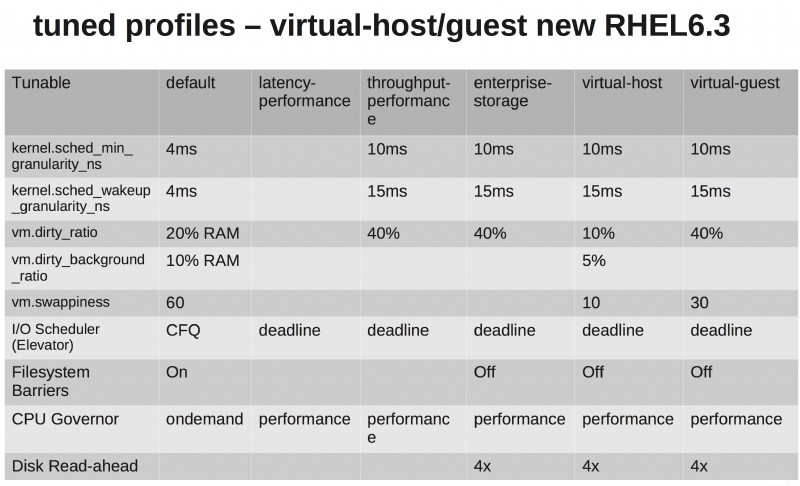

Je pense qu'il est utile de les voir sous forme de tableau. La principale chose à noter est que les paramètres par défaut de RHEL6 sont nuls !! L'autre chose est que les profils de stockage d'entreprise et d'invité virtuel sont identiques, à l'exception de la swappiness réduite du côté de l'invité virtuel (c'est logique, non ?).

En ce qui concerne une recommandation sur l'ascenseur d'E/S de stockage, vous avez quelques couches d'abstraction sur la couche de stockage. L'utilisation du planificateur noop aurait du sens si vous utilisiez des RDM ou présentiez le stockage directement sur vos machines virtuelles. Mais comme ils vont vivre sur NFS ou VMFS, j'aime toujours les options de réglage supplémentaires offertes par le planificateur d'échéance.

Les profils réglés peuvent être modifiés à la volée sur les systèmes en cours d'exécution, donc si vous avez des inquiétudes, testez avec votre application et votre environnement et votre référence spécifiques.

Regardez les vidéos de réglage des performances de Shak et Larry de Summit, ils parlent en profondeur des profils réglés.

- Partie 1 :http://www.youtube.com/watch?v=fATEiBJ3pKw

- Partie 2 - http://www.youtube.com/watch?v=km-vLELmWLs

L'un des principaux points à retenir est que les profils ne sont qu'un point de départ recommandé, et non des nombres immuables qui sont magiquement parfaits pour chaque environnement.

Commencez avec un profil et jouez avec les paramètres. Générez une bonne charge de travail de test de type production et mesurez les métriques qui sont importantes pour votre entreprise.

Changez une chose à la fois et enregistrez chaque résultat à chaque itération. Lorsque vous avez terminé, examinez les résultats et choisissez les paramètres qui ont donné les meilleurs résultats. C'est votre profil idéal.

La réponse courte est que tout réglage est une conjecture et n'a de valeur que s'il est étayé par des données empiriques :essayez-le. Mesure le. Si vous ne l'aimez pas, modifiez-le.

Une réponse plus longue :

Augmenter le dirty_ratio signifierait probablement des performances d'écriture plus élevées ... IO sera bloqué pendant un temps considérablement plus long

Non. L'augmentation du taux de saleté signifie que votre système est moins susceptible d'entrer dans un état où il doit commencer à bloquer les écritures. L'inconvénient est qu'il y a plus de mémoire utilisée et un plus grand risque de perte de données en cas de panne.

ce qui signifie que les tâches en cours auront plus de temps pour terminer leur travail

Les processus céderont généralement avant que leur tranche de temps n'expire. Le problème avec une machine virtuelle est que votre machine peut être en concurrence pour le processeur et le cache L1/L2 avec d'autres machines virtuelles - des niveaux élevés de commutation de tâches (en raison de la préemption) ont un impact important sur le débit. Le type d'applications qui sont généralement déployées dans les machines virtuelles sont celles qui sont liées au processeur (serveurs Web, serveurs d'applications).

Oui, l'augmentation du débit (qui s'applique à tous les types d'application) se fera au prix d'une augmentation de la latence - mais cette dernière est de l'ordre de la microseconde alors que la plupart des transactions prennent des millisecondes. Si vous avez besoin d'une capacité en temps réel/d'une latence très faible, vous ne devriez pas utiliser de machine virtuelle.