Dans ce didacticiel, nous allons vous montrer comment installer Apache Spark sur le serveur CentOS 7. Pour ceux d'entre vous qui ne le savaient pas, Apache Spark est un système informatique en cluster rapide et polyvalent . Il fournit des API de haut niveau en Java, Scala et Python, ainsi qu'un moteur optimisé qui prend en charge les graphiques d'exécution globaux. Il prend également en charge un riche ensemble d'outils de niveau supérieur, notamment Spark SQL pour SQL et le traitement des informations structurées, MLlib pour la machine l'apprentissage, GraphX pour le traitement des graphes et Spark Streaming.

Cet article suppose que vous avez au moins des connaissances de base sur Linux, que vous savez utiliser le shell et, plus important encore, que vous hébergez votre site sur votre propre VPS. L'installation est assez simple et suppose que vous s'exécutent dans le compte root, sinon vous devrez peut-être ajouter 'sudo ‘ aux commandes pour obtenir les privilèges root. Je vais vous montrer l'installation étape par étape d'Apache Spark sur le serveur CentOS 7.

Installer Apache Spark sur CentOS 7

Étape 1. Tout d'abord, commençons par nous assurer que votre système est à jour.

yum clean all yum -y install epel-release yum -y update

Étape 2. Installation de Java.

Installation de Java pour l'installation requise d'apache-spark :

yum install java -y

Une fois installé, vérifiez la version java :

java -version

Étape 3. Installation de Scala.

Spark installe Scala pendant le processus d'installation, nous devons donc simplement nous assurer que Java et Python sont présents :

wget http://www.scala-lang.org/files/archive/scala-2.10.1.tgz tar xvf scala-2.10.1.tgz sudo mv scala-2.10.1 /usr/lib sudo ln -s /usr/lib/scala-2.10.1 /usr/lib/scala export PATH=$PATH:/usr/lib/scala/bin

Une fois installé, vérifiez la version scala :

scala -version

Étape 4. Installation d'Apache Spark.

Installez Apache Spark à l'aide de la commande suivante :

wget http://www-eu.apache.org/dist/spark/spark-2.2.1/spark-2.2.1-bin-hadoop2.7.tgz tar -xzf spark-2.2.1-bin-hadoop2.7.tgz export SPARK_HOME=$HOME/spark-2.2.1-bin-hadoop2.7 export PATH=$PATH:$SPARK_HOME/bin

Configurez certaines variables d'environnement avant de démarrer Spark :

echo 'export PATH=$PATH:/usr/lib/scala/bin' >> .bash_profile echo 'export SPARK_HOME=$HOME/spark-2.2.1-bin-hadoop2.6' >> .bash_profile echo 'export PATH=$PATH:$SPARK_HOME/bin' >> .bash_profile

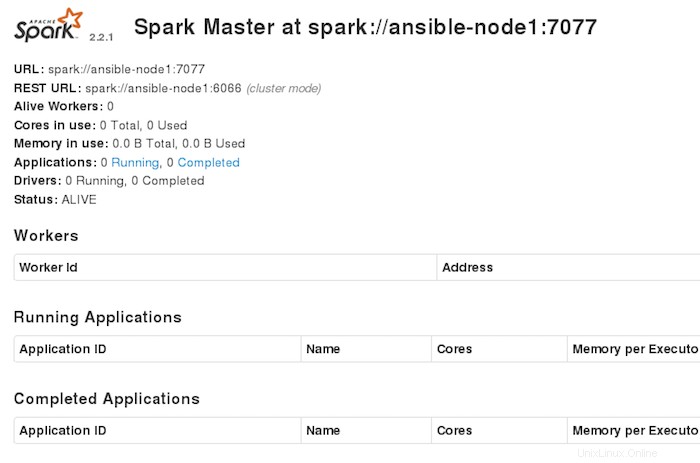

Le cluster Spark autonome peut être démarré manuellement, c'est-à-dire en exécutant le script de démarrage sur chaque nœud, ou simplement en utilisant les scripts de lancement disponibles. Pour les tests, nous pouvons exécuter des démons maître et esclave sur la même machine :

./sbin/start-master.sh

Étape 5. Configurez le pare-feu pour Apache Spark.

firewall-cmd --permanent --zone=public --add-port=6066/tcp firewall-cmd --permanent --zone=public --add-port=7077/tcp firewall-cmd --permanent --zone=public --add-port=8080-8081/tcp firewall-cmd --reload

Étape 6. Accéder à Apache Spark.

Apache Spark sera disponible sur le port HTTP 7077 par défaut. Ouvrez votre navigateur préféré et accédez à http://yourdomain.com:7077 ou http://your-server-ip:7077 et suivez les étapes requises pour terminer l'installation.

Félicitations ! Vous avez installé avec succès Apache Spark sur CentOS 7. Merci d'avoir utilisé ce didacticiel pour installer Apache Spark sur les systèmes CentOS 7. Pour obtenir de l'aide supplémentaire ou des informations utiles, nous vous recommandons de consulter la version officielle d'Apache Site Web Spark.